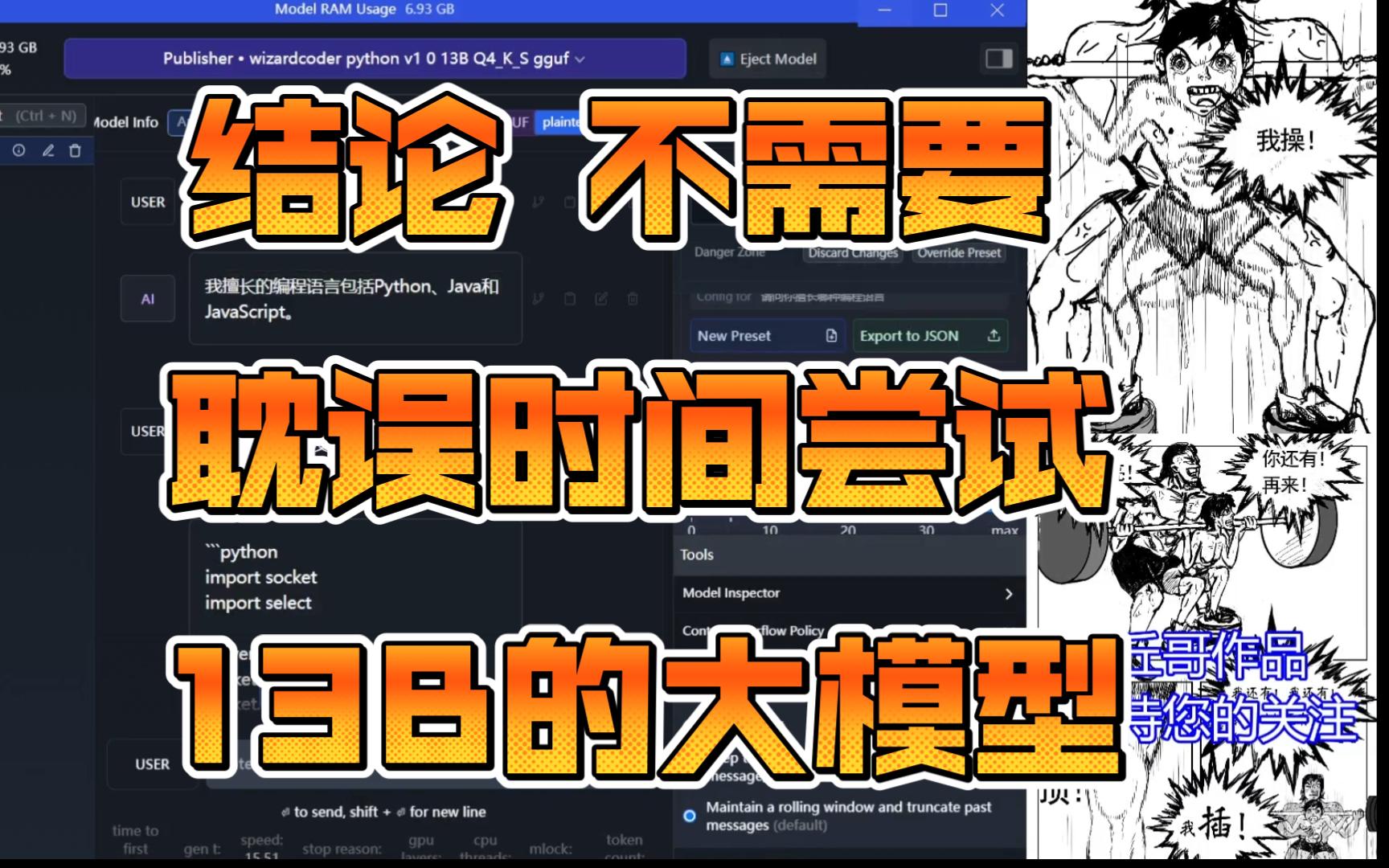

【13B大模型无用】大家不需要用自己的8G显存跑大模型了,没意义,70B也许成,我试试

绿铀:

绿铀:

啊,不是吧。我做过实验,普通人根本分不清14b的通义千问和gpt3.5的[doge]一般32b足够跑了。

【回复】回复 @绿铀 :好的。

不过我现在用得最多的是32B_q6_k。

这也说明损失只是让模型更加偏离开发者的预期,除了可能效果变差,也可能效果变好。

不过后续新开源的模型明显是做了改进的。

32B和110B文笔都还行。就中间的72B惜字如金。写个散文像记流水账一样。

【回复】回复 @CLINLX :给个建议,我这边测试发现一个非常牛逼的问题。

32b-q3的质量比32b-q4,q5高。使用14b不如直接使用32b-q3

至少在我这边,14b-q6没有32b-q3质量高。

我个人是不知道这是什么原理的,但是我发现很多模型的留言也出现了这种情况,q3,q6的性能反而比q8,f16的质量好。

【回复】千问1.5的14B是聊天流畅的水平。作为地道的翻译也非常流畅。

而更低的模型就好在翻译时逐字机翻,甚至中英文夹杂。

千问32B是性价比最高的模型。单卡显存大点的40系就能跑。完全可以替换GPT3.5的使用。而且32B在文学创作上独树一帜,甚至超过了70B。[doge] 西西东东小学生:

西西东东小学生:

7B应该可以吧,以前看了教程记得是7G多,没有显卡来试等山丘哥试来看看[打call]

【回复】以前觉得CPU不够,后来觉得内存不够,然后觉得显卡不够,居然硬盘也开始觉得不够,总结起来是钱不够,慢慢怀疑应该技术不够,终于知道大厂说的时间不够,高端人才不够[笑哭]毕竟人家至少不太差钱把吧

【回复】回复 @MK山丘哥 :不要又干通宵哦[吃瓜] 西西东东小学生:

西西东东小学生:

个人建议,[doge]服务器搭起来,直接干,出问题再说[doge]怕个毛线 西西东东小学生:

西西东东小学生:

扎克伯格几百亿美刀想那么多不也什么都不剩,开放,包容,搞,先干了再说,跑起来或许有新目标的 anrgct:

anrgct:

本地生成代码,starcode2,llama3,codeqwen,phi3还不错,最好用q8,fp16,或者原版的 噗噗噗巴闭七:

噗噗噗巴闭七:

那本地的哪个靠谱呢大佬 写程序辅助用的话

【回复】编程我们应该是不用担心的,至少我们自己基础的都可以,其他免费的简单修改一下就差不多了,前端后端过程都这样复刻搞下去不大科学吧,还不如GIT找一些开源的项目弄上去就行了,弄下去太费时间,项目先跑起来,要不团队容易失去凝聚力,站在巨人的肩膀上再发展自己,停下来很容易迷失

【回复】回复 @噗噗噗巴闭七 :要不,你等我裁切成功了,再买,别亏了

【回复】回复 @MK山丘哥 :好的谢谢 持续关注大佬 西西东东小学生:

西西东东小学生:

上几个角色,场景上去跑起来再说,有信心才有团队 Gabrielusの哆啦考尔:

Gabrielusの哆啦考尔:

没用倒不至于,纯英文的7b mistral能在树莓派上跑,加一个ttl做语音助手就很棒

【回复】回复 @Gabrielusの哆啦考尔 :有道理,抽空我也搞一个