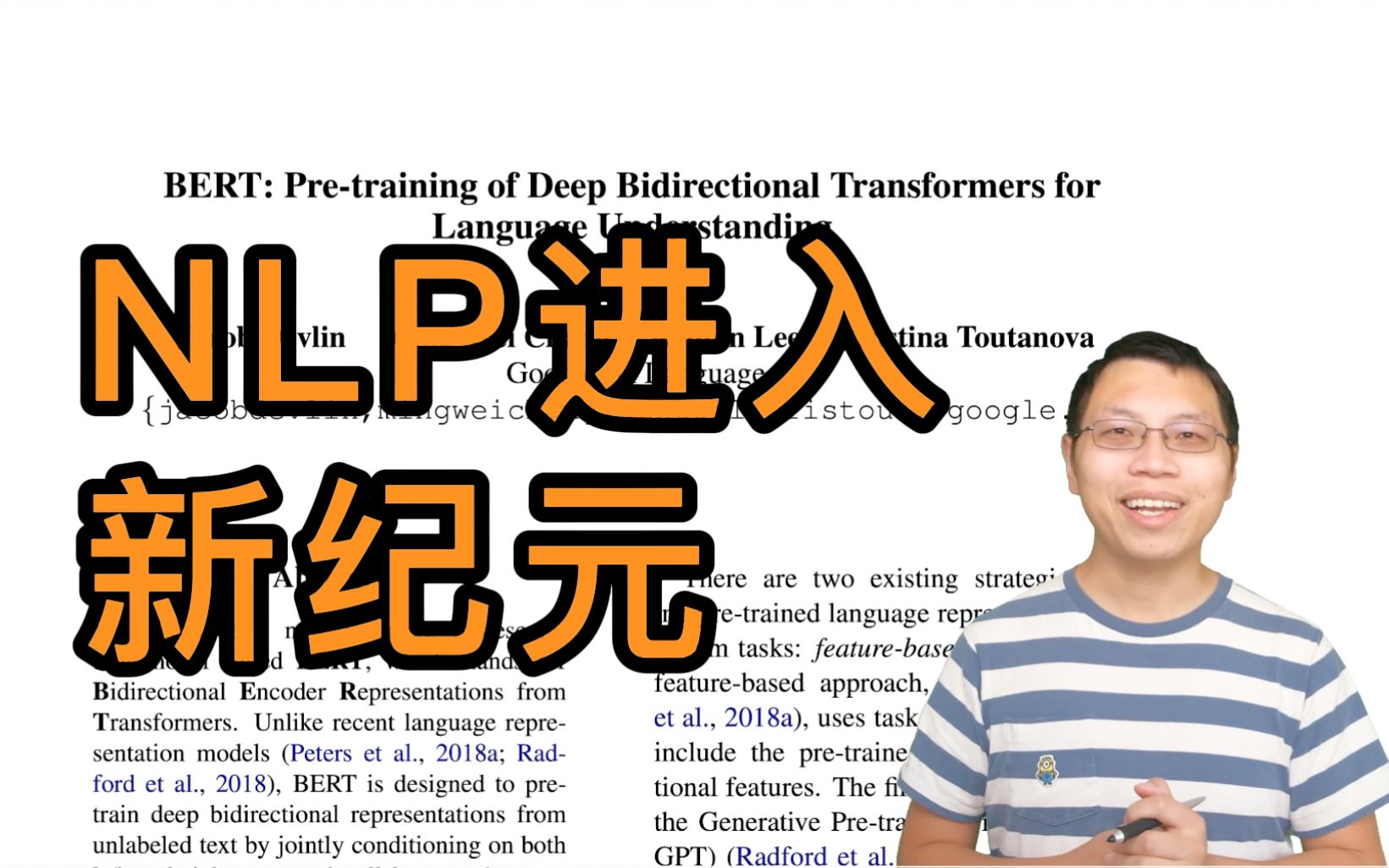

BERT 论文逐段精读【论文精读】

不爱吃花椒的刺猬酱:

不爱吃花椒的刺猬酱:

1.摘要(Abstract):与别的文章的区别是什么?效果有多好?

2.引言(Introduction):语言模型的简单介绍;摘要第一段的扩充;主要想法;如何解决所遇到的问题;

贡献点:双向信息的重要性(句子从左看到右,从右看到左)、在BERT上做微调效果很好、代码开源

3.结论(Conlusion):无监督的预训练很重要(在计算机视觉领域,在没有标签的数据集上做训练比在有标签的数据集上做训练效果会更好);主要贡献是将这些发现进一步推广到深度双向架构,使相同的预训练模型能够成功处理一系列的 NLP 任务。

在本篇论文的结论中最大贡献是双向性(在写一篇论文的时候,最好有一个卖点,而不是这里好那里也好)。

选了选双向性带来的不好是什么?做一个选择会得到一些,也会失去一些。

缺点是:与GPT(Improving Language Understanding by Generative Pre-Training)比,BERT用的是编码器,GPT用的是解码器。BERT做机器翻译、文本的摘要(生成类的任务)不好做。

但分类问题在NLP中更常见。

完整解决问题的思路:在一个很大的数据集上训练好一个很宽很深的模型,可以用在很多小的问题上,通过微调来全面提升小数据的性能(在计算机视觉领域用了很多年),模型越大,效果越好(很简单很暴力)。

【回复】建议修正:“无监督的预训练很重要(在计算机视觉领域,在没有标签的数据集上做训练比在有标签的数据集上做训练效果会更好)” 修正为 (在计算机视觉领域,在''大量的''没有标签的数据集上做训练比在''少量的''有标签的数据集上做训练效果会更好)

【回复】学习!https://www.bilibili.com/read/cv14220273?spm_id_from=333.999.0.0[打call] 霍华德vlog:

霍华德vlog:

我觉得BERT能爆火的一大原因是他提供了很多种语言的预训练模型,大家都拿去一试,发现真的很好用。从而引发了狂潮。与此相比,很多很好的工作,只开源代码,没开源参数,其他人没办法快速在自己的场景上验证效果,严重影响了这些工作的impact

【回复】这个是一个大原因,gpt系列没有来源模型是一大硬伤

【回复】回复 @跟李沐学AI :沐神怎么学会挖坑了 看完视频就很想知道为什么Bert能出圈 DASOU讲AI:

DASOU讲AI:

老师讲的非常好,大家可以使用下面面试题看一下自己有没有真的掌握bert模型。

1. BERT分为哪两种任务,各自的作用是什么;

2.在计算MLM预训练任务的损失函数的时候,参与计算的Tokens有哪些?是全部的15%的词汇还是15%词汇中真正被Mask的那些tokens?

3.在实现损失函数的时候,怎么确保没有被 Mask 的函数不参与到损失计算中去;

4.BERT的三个Embedding为什么直接相加

5.BERT的优缺点分别是什么?

6.你知道有哪些针对BERT的缺点做优化的模型?

7.BERT怎么用在生成模型中?

【回复】1.BERT模型有两种主要的任务:

Masked Language Model(MLM,遮盖语言模型):这种任务的目的是预测句子中部分单词的原始形式。在训练过程中,BERT模型会随机选择一些单词并用“【MASK】”标记替换它们。模型的任务是预测被替换的单词的原始形式。这种方法可以使模型在理解句子语义的同时学习到词语之间的关系。

Next Sentence Prediction(NSP,下一句预测):这种任务的目的是预测一个句子是否是另一个句子的下一句。在训练过程中,BERT模型会从两个句子中选择一个随机的句子对,并根据是否是下一句来训练模型。这种方法可以使模型更好地理解上下文之间的关系。

【回复】回复 @Mkiolopil : 2.在计算MLM(遮盖语言模型)预训练任务的损失函数时,参与计算的tokens只包括真正被Mask的那些tokens。

具体来说,在训练过程中,BERT模型会随机选择一些tokens并用“【MASK】”标记替换它们。这些被标记的tokens只占所有tokens的一小部分,通常是15%。然后,模型的任务是预测被替换的tokens的原始形式。在计算损失函数时,只有真正被替换成了“【MASK】”标记的tokens会被用来计算损失值,而没有被标记的tokens则不会参与损失函数的计算。 罗辑往事:

罗辑往事:

老师 新设备让您的声音更有磁性了[doge] 单位年:

单位年:

我发布了一篇笔记,快来看看吧

BERT: 近 3 年 NLP 最火 CV: 大数据集上的训练好的 NN 模型,提升 CV 任务的性能 —— ImageNet 的 CNN 模型 NL...

https://www.bilibili.com/h5/note-app/view?cvid=14068934&pagefrom=comment youpuderen:

youpuderen:

期待prompt论文 因为本来觉得nlp只能预训练finetune走到死了 prompt这几个月的文章还蛮让人期待的 涼宮春日的柚子:

涼宮春日的柚子:

导师,可以有机会讲一讲因果推断吗[打call]

【回复】最近对bengio讲的system2很感兴趣,现在不知道有没有这方面的进展 fdhyhtt:

fdhyhtt:

Abstract

NLP在Bert之前一直没有一个深度神经网络训练好之后,可以解决大部分任务。用一句话来概括Bert,就是Bert是一个深的双向的Tran... 林小得:

林小得:

Muti-head Self-Attention 可学习参数是第四个子图中的Wq,Wk,Wv, 都是H×H的正方形(H是输入的向量dim)

结合Trans... 维也纳艺术学院主考官:

维也纳艺术学院主考官:

能不能搞一个NLP的模型,让它自己去看文献然后生成文章呢[辣眼睛]

【回复】TP过来,已经可以了,哈哈哈哈哈哈

【回复】回复 @江姜将降 : Chat-GPT[妙啊]

【回复】程老师这个艰巨的任务就交给你了,我投资十块 如果我是泡橘子:

如果我是泡橘子:

我发布了一篇笔记,快来看看吧

BERT pre-training of deep bidirectional transformers for language understan...

https://www.bilibili.com/h5/note-app/view?cvid=14514000&pagefrom=comment Chier张:

Chier张:

李沐老师!求出transformer在cv的应用系列!!![星星眼][给心心] 长玄风木:

长玄风木:

老师,我之前一直有一个疑问,就是bert和他的衍生模型已经达到了非常好的效果,但是现在已有的很多相关工作,比如说多模态,仍然基于textcnn glove之类的模型来生成预处理的向量,这是因为老师讲到的bert的输出静态向量效果没有微调好吗?挺不理解的。。 写bug滴随意凯:

写bug滴随意凯:

亚马逊首席科学家 不讲讲推荐系统吗[打call][打call]